Statskontoret har fått ett uppdrag att utföra en myndighetsanalys av DIGG Pdf

Känns som civilsamhället borde vara med och tycka till

- jag har en skuggbacklog där jag samlar udda saker med DIGG, saker som dom lovar, kompetenser dom borde ha se Länk DIGG skuggbacklog

Tror det finns fördelar om flera skriver ned sina förväntningar på ett strukturerat sätt

- liknande med Skuggbacklog Riksdagens Öppna data / projekt Nationell Dataverkstad

Exempel på projekt som visar hur stor utmaning det är för staten att skapa bra digitala lösningar med interoperabilitet och hur låg kompetens och leveransförmågan som finns idag 2022

-

Rättsinformationssystemet startade 1986 en förstudie , 1999 skapades SFS 1999:175 som sa att Domstolsverket skull ansvara för att en dokument typ myndigheters författningar skulle skapas på ett enhetligt sätt av 100 olika myndigheter… idag 26 år senare har man lyckats skapa 100 länkar och ingen kontroll verkar finnas hur man skall gå vidare

- Domstolsverket verkar ha givit upp 2016 dec 13 och tror att Regeringskansliet har bollen men kollar man med Regeringskansliet (se issue #3) 2022 så tror dom att

Justitiedepartementet driver detta. En variant är att trots allt snack om att Sverige skall bli bäst i världen att ta han om digitaliseringen möjligheter så fegar man ur och även formellt upphäver SFS 1999:175 - avdelningen mycket snack och liten verkstad … - att DIGGs som myndighet nu verkar ifrågasättas och skall granskas redan efter 3 år känns som det är många kockar men ingen klarar av att laga soppan…

… - att DIGGs som myndighet nu verkar ifrågasättas och skall granskas redan efter 3 år känns som det är många kockar men ingen klarar av att laga soppan…

- Domstolsverket verkar ha givit upp 2016 dec 13 och tror att Regeringskansliet har bollen men kollar man med Regeringskansliet (se issue #3) 2022 så tror dom att

Jag tror civilsamhället måste våga ställa krav på digitalisering se hur kommuners beslut kungörande idag 2022 är ett kaos länk “Problem identifierade med dagens Anslagstavla” med 290 SILOS

- ett grundfel jag ser är att det saknas grundläggande tankar om hur kravinsamlingen skall ske se Nationell dataverkstad och Matsvinn där har Södertälje kommun “hittat på” ett dataset med några fält, Livsmedelsveket har ett felårigt projekt om matsvinn

- där borde DIGG kunna peka på att det finns en kunskapsgraf där alla aktörer identifieras med persistenta identifierare och alla deras user cases har unika persistenta identifierare ungefär som mina skuggbackloggar ovan… då kan man enklare se om olika datamängder matchar varandra eller inte

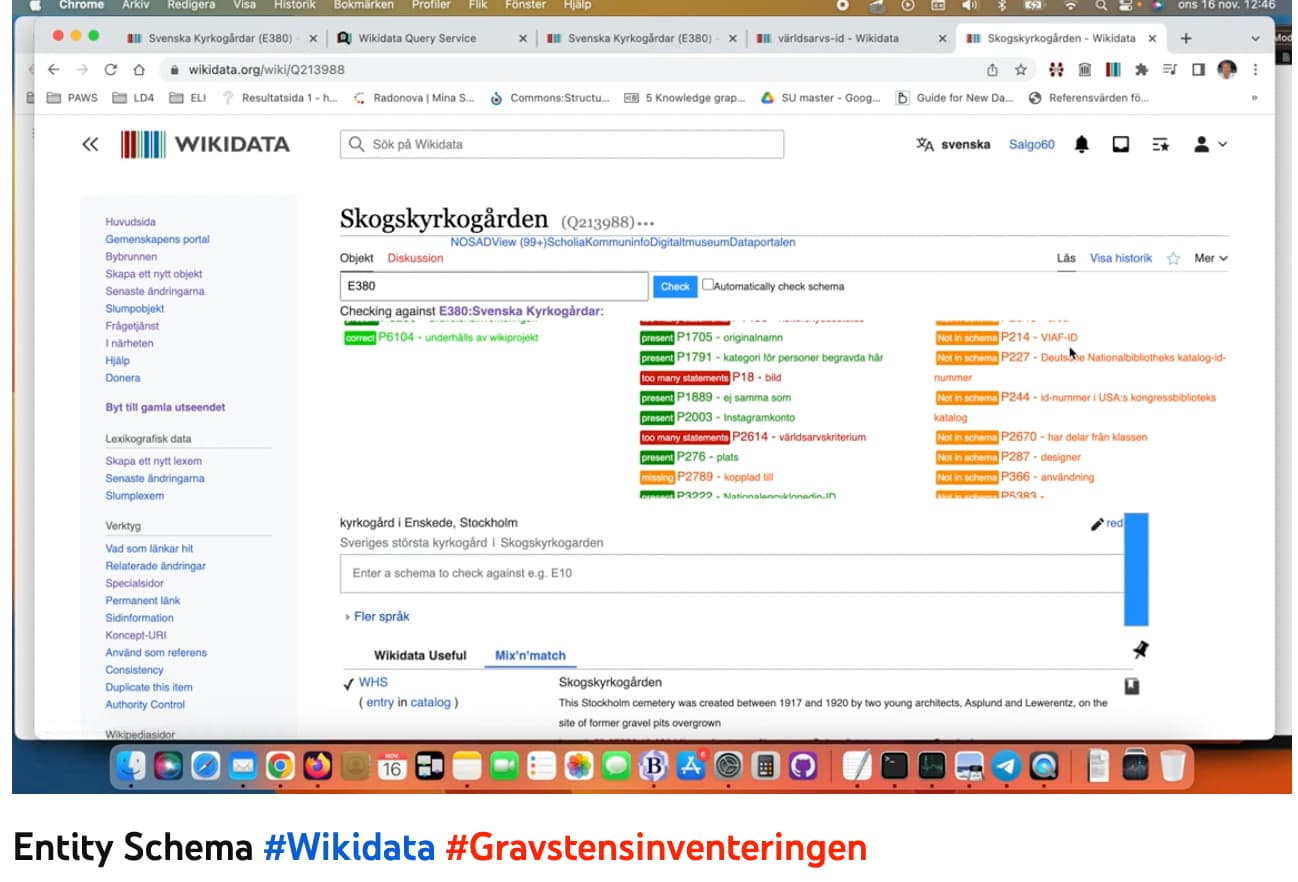

- rent tekniskt kör Wikidata ShEx för att maskinellt kunna validera datamängder om dom uppfyller en shEx spec se Badvatten E:319 - tycker det fungerar sådär behövs bättre verktyg…